The 61st Annual Meeting of the Association for Computational Linguistics (ACL2023)は7月9日から14日までの日程で、カナダのトロントで開催されました。ACLは計算言語学や自然言語処理の分野でのトップカンファレンスの1つです。Program Chairsによる詳細なレポートも公開されています。初参加ですが、大規模言語モデルとも呼ばれるLarge Language Models(LLMs)がこの分野でも存在感を増していることを実感しました。

その結果、今回の出張報告を要約すると、「LLMsの世界を現代からタイムマシンに乗り未来まで見てきた」となります。

年年歳歳

トロントといえば、CNタワー、足を延ばせばナイアガラと高さを意識させるランドマークが有名である。12年ぐらい前に初めてトロントに来た時にはCNタワーの高さに驚いたが、今回は高層ビルが増えたこともあり、その高さに以前ほど圧倒されなくなった。こちらは都市景観の変化であるが、変化は計算機を用いた自然言語処理の分野でも起きていた。変化というより革命の方が実態に合っているかもしれない。

ナイアガラと言えば、学生時代の「定期試験」前日に先輩から渡された本がある。先輩は「明日の試験にこの本が役に立つ」と言って紙袋を渡したので、その中身を家で確認すると入っていたのは、スポーツ漫画の金字塔とも言える「アストロ球団」だった。一般には「ジャコビニ流星打法」が有名だが、自分は「人間ナイアガラ」に最も衝撃を受けた。翌日の試験に役立ったのか断言できないが、今でも「新規性」や「インパクト」を評価する時に、「人間ナイアガラ」を想起していることは断言できる。先輩は翌日の試験より先を見据えこの本を紹介してくれたのだろうか?

自然言語処理におけるLLMs

Deep Learningはここ数年、自然言語処理(NLP:Natural Language Processing)の世界でも存在感を増していた。今回の会議で、既存手法のオルタナティブというより、その成果である学習済み言語モデルがインフラとして定着しつつあるという変化というか、まさに革命を感じた。それが最近生成AIの手段として一般にも浸透しているLarge Language Models (LLMs)である。少し前まではPre-trained Large Language Models (PLMs)とも言われていた。これらモデルによりNLPはテキスト集合やコーパスよりはLLMsに向き合う分野になりつつある。この方向性は、テキストやそれを構成する単語やトークンが全て意味的かつ加法性を持つ表現の学習、表現学習が注目されるようになった頃から始まっていたので、いまさら驚くべきことではないかもしれない。何度も耳にした「ダウンストリームタスク」という用語が脳内でナイアガラを連想した。

LLMsがNLPの分野でも人気がある理由は、1)我々がNLPのメインタスクへ集中することができるようになり、かつ2)この分野の新規参入のハードルを下げた事があると思われる。具体的にはインプットとなるテキスト集合の収集や整形などのコストの高い処理をLLMsは既に完了し内部に取り込んでいるため、利用者はLLMsを使うことで、この処理をスキップしてタスクの設計に集中できる。またLLMsはテキストデータに加え、モデルによってはKnowledge Graph(KG)などのデータも、統一したインタフェースで我々のアクセスを可能にする。その一方でLLMsを利用する場合、メモリ等のリソース管理や、ライブラリ群のバージョン管理等々開発レベルの知識も必要になってきた。従って、研究者として活躍するにはエンジニア並みのスキル習得も欠かせず、その結果、開発者との違いはアウトプットの違いであり、ますます両者の境界が曖昧になってきていると会議で感じた。

かつて「データサイエンティストの育成」についても「エンジニアを育成するのが最も効率的」という話を聞いた事があり、その育成の話はこの分野にも当てはまると感じた。

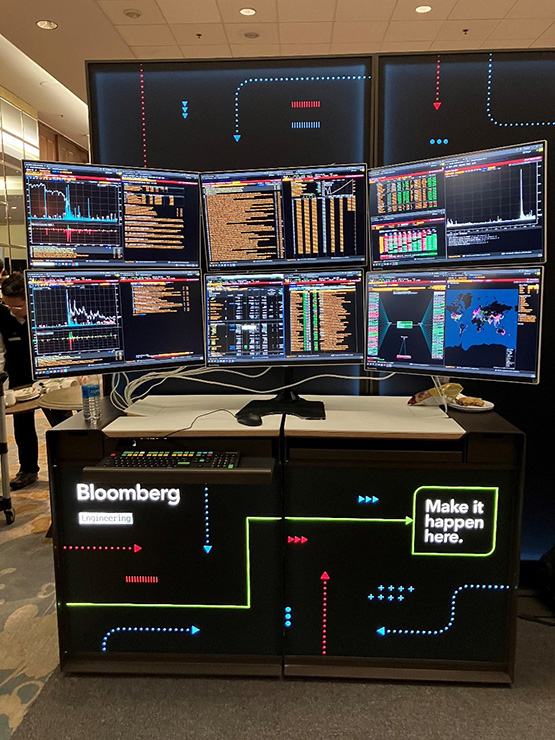

企業ブースには人材担当やリクルータの人が多いので、今回も研究者と開発者との違いについて聞いてみたが、今回は違いに関してはあまりなく、むしろ両者に共通して「コミュニケーションスキルの高さ」を求めている事が印象的だった。具体的には「自分の言葉で伝えられる事」であり、「人の話を聞ける事」であるようだ。それらができて、成長が持続し、変化の激しい業界で生き残ることができるのだろうと感じた。

また、コミュニケーションは人間関係だけでなくLLMsとの関係でも重要なことを痛感した。LLMsに「いいアウトプットを出してほしい」、あるいは「タスクを実行してほしい」と思うなら、LLMsにも人と同じように丁寧かつ正確な指示が必要である。要はLLMsを活かせるPromptを設計でき、与えられるかにある。

論文紹介

ここではLLMs関連で気になった研究を1)LLMsの現在、2)LLMsの応用、3)LLMsの未来の3部構成で紹介したい。紹介する論文は私の目から見て彗星の輝きを放つ論文の一部である。言語モデルの表現として学習済みの言語モデル(PLM)とLLMが混在するが、ここではその表現は該当論文に合わせている。PLMsやLLMsとsがつく場合は複数のモデルを意味している。両者の違いが気になるが、モデルを事後学習する場合はPLM、Promptやlearningでモデルの創発性を引き出す場合はLLMと区別しているように見える。

1) LLMsの現在

PLMに知識を追加する手法であるKnowledge Injectionについての論文を紹介する。

Xu, Yan, et al l: KILM: Knowledge Injection into Encoder-Decoder Language Models

この論文では、継続的な事前学習を通じて、encoder-decoder typeのPLMs(論文ではBART)にentity(知識グラフのノード。学習コーパスとしてよく使われるWikipediaであれば、各ページ内で言及されているトピック(人、事象など説明の対象)がノードに相当する)関連の知識を注入するアプローチ、KILMを提案。KILMの目的は与えられたコンテクストに出現する概念やentityに関する追加コンテンツをPLMsに教えることで、PLMsがentityへの言及を追加情報で根拠づけ、それが何かを「記述」できるようにすることである。そのため、KILMはPLMコンテクストメーターの導入やモデルのアーキテクチャ変更に代わり、PLMsが持つ事前訓練目標に加え、Knowledge Masking及びMasked Knowledge Reconstructionを採用している。

このアプローチはPLMsの性能を向上させる一方で、PLMsが持つ知識の壊滅的な忘却を回避するだけでなくentityの知識やエッジの明確な構造により、さまざまな文脈で注入された知識を柔軟に探索する上で有効であることが期待できる。

Gu, Y, et al: Pre-Training to Learn in Context

この論文はLLM等の言語モデルの文脈内学習(in-context learning (ICL))の能力を発揮するためのフレームワークとしてPICL (Pre-training for In-Context Learning)を提案。PICLは「テキスト文書の多くの段落に内在的タスクが含まれている」という観察に基づき、ICLの能力向上のために、一般的な平文コーパスに含まれる同じ固有タスクを持つ段落を集めて連結することでmeta-training datasetを構築し、コンテクスト内の段落に対して固有タスクの条件付けを行うように言語モデルを事前学習させる。

その事前学習で得たタスク汎化を維持しながら、PICLはタスクを推測し実行する。実験では7種のテキスト分類及び SUPER- NATURALINSTRCTIONSのデータセットを用い、その検証結果を示している。結果ではPICLを適用したモデルは汎化性能を維持しつつ、その4倍近いパラメタを持つモデルに匹敵するか、それを上回るICLの性能向上が示されている。

Zhao, X, et, al: Pre-trained Language Models Can be Fully Zero-Shot Learners

本論文では、完全にzero-shotの言語理解のためのノンパラメトリックプロンプティングPLM(NPPrompt)を提案。事後学習を要する従来アプローチと異なり、NPPromptはPLMのみを使用し、さらなる微調整のためのラベル付きデータや追加の生コーパスを必要としない、zero-shotスタイルの言語理解をめざしている。

具体的にはNPPromptはPLMの初期単語埋め込みを用いてカテゴリ名の関連語を自動的に検索し、ラベル単語を生成、ロジットを集計することで、最大のスコアを持つカテゴリを予測する。その結果、NPPromptはPLMのパラメタは凍結したままで、かつ手作業による設計あるいはラベル付けされたコーパスを使用せずに、zero-shotスタイルで単語からラベルへマッピングするVerbalizerを構築できる。実験はNPPromptをfew-shotそしてzero-shotスタイルの学習方法をテキスト分類、類似テキスト検索等のNLPタスクで比較し、その効果を示している。

Lu, J, et al: What Makes Pre-trained Language Models Better Zero-shot Learners?

zero-shotシナリオのプロンプト学習は最適なプロンプトテンプレートを選択するため、人手によるラベル付きデータを必要とする。著者らはこれらデータを利用できないzero-shotシナリオのプロンプトでは実用的でないことを指摘し、人間による注釈付きのデータを一切使用せずにテキスト分類で妥当性のあるプロンプトテンプレートをスクリーニングするための手法としてPerplexity Selection (Perplection)を提案。

著者らはプロンプト学習によりLLMが特徴抽出に加え、予測でも効果を発揮することに着目し、事前学習と下流タスクの組み合わせに言語間の不一致があることを指摘した。Perplectionはこの不一致をテンプレートの有効性を測定するために使用できるという仮説に基づく、テンプレートの性能の事前予測を可能にするperplexityベースの手法である。

Knowledge distillation (KD)を用いたchain-of-thought (CoT) モデルも興味深い。

Wang, P, et al: SCOTT: Self-Consistent Chain-of-Thought Distillation

著者らはCoTプロンプトは理論的根拠が言語モデルの予測と一致、あるいはモデルの決定を忠実に正当化していることを保証していないことを指摘し、信頼できるCoT推論を引き出すための知識蒸留法(KD)であるSCOTTを提案。SCOTTでは大規模な言語モデルを教師モデルとし、contrastive decodingにより質問と回答のペアに対してその根拠を生成するように指示し、次に小規模な生徒モデルが、counterfactual reasoningにより根拠と回答を生成するように事後学習させている教師から学習し、自身の予測と一致するCoT推論を生成する。

2) LLMsの応用

検索エンジンはLLMsと相性が良いため、LLMベースの検索エンジンの研究も活発である。

Ziems, N, et al: Large Language Models are Built-in Autoregressive Search Engines

背景としてDeep Learningを用いた文書検索にデュアルエンコーダ密検索エンジンと呼ばれるエンジンがあり、質問と文書を独立にエンコードすることでそれぞれの表現を取得し、両者の表現の類似性を計算することでそれらの関連性を推定する。既存のデュアルエンコーダ密検索エンジンは、質問と文書間の浅い相互作用しか許容しないという制限がある。この制限を克服するため、両者の類似性を計算する代わりに、自己回帰型検索エンジンは、候補プール中の関連文書の識別子を直接生成する。例えば、生成する識別子にはWikipedia pageのタイトルや特徴的なn-gramなどがある。一方で自己回帰型検索エンジンの学習コストは、候補文書の数が増加するにつれて急激に上昇することが知られている。

著者らが提案するLLM-URLは、LLMをベースにした検索において、LLMが人間の指示に従い、文書検索のために直接生成したURLを用いた検索エンジンである。

論文中では、いくつかのクエリとURLのペアをインコンテクストで示すと、LLMは対応するドキュメントの90%近くがオープンドメインの質問に対する正しい回答を含むWeb URLを生成できたと報告している。LLM-URLはこのURLを介して取得した文書群をランク付けし、そこから回答を出力する。この結果を見ると、LLMも検索エンジンの機能を内包していることを示唆している。

PLMのマルチモーダルへの応用研究を紹介する。

Du, Y, et al: Zero-shot Visual Question Answering with Language Model Feedback

最近のLLMは入力されるテキストだけでなく画像も理解できるようになっている。

PLMsは背景知識、あるいは常識的な推論や論理的推論のような複雑な推論を要するタスクでも優れた能力を発揮するので、vision-languageのタスクにも適用されている。

PLMベースのVisual Question Answering(VQA)にはPLMの適合あるいはfew-shotやzero-shotで活用するアプローチがある。

後者のアプローチにより生成されたキャプションは、VQAタスクへの情報量が少なく、タスクにおける質問と無関係になることがあるという課題に著者らは着目した。その解決策として著者らはLAnguage MOdel guided Captioning (LAMOC)を提案。LAMOCは画像からテキストを生成するCaptioning modelとPLMの構成において、VQAタスク向けにPLMが情報量の多いキャプションを生成するために、Captioning modelを訓練するアプローチである。第1段階では、Captioning modelをPLM(予測モデル)に適合させ、第2段階では、強化学習を適用し、タスクの目標に従いPLMのフィードバックから学習することでCaptioning modelを調整することでその能力を向上させる。

Huang, Y, et al: MVP-Tuning: Multi-View Knowledge Retrieval with Prompt Tuning for Commonsense Reasoning

著者らは推論タスクのマルチホップ知識検索で獲得された知識に埋め込まれたノイズによる精度低下という課題に着目し、論文で常識的な推論のQAシステムを構築するためのアプローチとしてMulti-View Knowledge Retrieval with Prompt Tuning (MVP-Tuning)を提案した。

3) LLMsの未来

Mai, F, et al: HyperMixer: An MLP-based Low Cost Alternative to Transformers

背景として多くのLLMがそのアーキテクチャとして採用しているTransformerは、入力の長さに対して2次関数的な複雑さを持ち、多くの学習データを必要とし、チューニングの困難さから、コストが高いことが知られている。この論文でも述べられているように、このコスト問題を解決するため、アーキテクチャをMLPで実装するMLPMixerなどのアプローチもあり、computer visionで使われている。

著者らはこれらのMLPベースのモデルは自然言語理解に必要な帰納バイアス(学習バイアスとも言われる)を欠いていることを主張し、この課題を解決するために、Transformerのアテンションメカニズムと同様に、位置不変の方法で入力データのサイズに合わせて変化できるMLPを生成する。トークン・ミキシングとしてアテンションを使用する場合、レイヤー全体がTransformerのエンコーダ・レイヤーに相当する。実験ではHyperMixerはTransformerと同程度の性能を持ちながら、処理時間、学習データ、ハイパーパラメタのチューニングの面で、コスト低減を実現したことを示している。

Jiang, D, et al: LLM-BLENDER: Ensembling Large Language Models with Pairwise Ranking and Generative Fusion

本論文は複数のオープンソースのLLMの多様な強みを活用し、優れた性能を発揮するように設計したアンサンブルフレームワークを提案。異なるインプットとアウトプットのペアに対して最適なLLMも異なるという観察に基づき、PAIRRANKER及びGENFUSERという2つのモジュールから構成される。PAIRRANKERは入力テキストと、それに対するLLMのペア(LLMsの中から2つを選択)がそれぞれ出力した候補テキストのペアをエンコードし、それをcross-attention encodersに入力し、どちらの候補テキストがより優れているかを決定する。次にこの決定プロセスを異なるLLMのペアについて実行する。最終的に全てのLLMのペアについて実行することで候補テキストの集合を得たのちに、GENFUSERはPAIRRANKERで上位の候補集合をマージして、最終的なアウトプットを出力する。

LLMの著作権も興味深い。それだけでなく上記の論文同様に、LLMsの進化の方向性を想像させてくれる。

Peng , W, et al: Are You Copying My Model? Protecting the Copyright of Large Language Models for EaaS via Backdoor Watermark

LLMのサービスであるEmbedding as a Service (EaaS)はモデル抽出攻撃に対して脆弱であることが示されている。LLMのトレーニングのコストは高いため、LLMの所有者は大きな損失を被る可能性がある。LLMの著作権を守るため、著者らはWatermarkingに着目し、EmbMarkerと呼ぶEmbedding Watermark methodを提案している。

LLMと個人的関心

機内では往復共にLLMsの検証目的で「ターミネーター ニュー・フェイト」を見た。

冒頭からお約束の「生体組織しか転送できないタイムマシンがどうしてターミネーターを現代に転送できるのだろう?」との疑問から始まり、見終わってLLMsは近いうちに、商業映画の制作にも使われるだろうと確信に至った。LLMsはマルチモーダルの分野でも使われ、マルチモーダルではテキストから動画を起こせるツールもある。商業映画となれば2時間前後の長さでストーリーだけでなく動画でも一貫性を持つことが求められるが、この要求に応えるのに、現在の技術更新の速さから言って5年もかからないだろう。

ターミネーターシリーズは今度こそ続編がないと言われているようで、大変心配している。続編をLLMやマルチモーダルを利用して作成すると、人間とAIの共存に新たなコンセプトを提供すると思う。

ターミネーターに特化したマルモーダルモデルがAPIで提供され、プロンプト(その時もその名称なのか?)を入力すればいつでも自分の好みのストーリーやビジュアルにカスタマイズしたターミネーターを観る事ができるようになるのではないか?

「ターミネーター ニュー・フェイト」の製作費は1億8,500万$とのことだが、モデルはprompt tuning + in contextの範囲であればそんなにかからないと思われるし、もともとCGなのでAIのモデルとも親和性が高そうだ。また、シリーズのお約束も多いのでcontext(テンプレート?)にも不自由しないのではないか?現時点の懸念はLLMsに本作のシナリオを執筆させた場合、本作の「カール、起きろ!」のような名台詞を含む事ができるかどうかである。もちろん、カーテンと部屋の関係に関する話もそうだが、サラ・コナーがあの時あの場所にどうして現れたかの明快な説明はできるかもしれない。LLMs及びそのマルチモーダルへの応用研究に励みとなった。

トロントへの道は険しかった。ワシントンでは乗り継ぎ便が欠航して1日足止めを食らい、ロストバゲージで荷物が3日間も行方不明となった。そのような艱難辛苦を乗り越え、会議に参加できたのも同僚や上司の深い理解と支援があったお陰である。出張中に出会った皆様、ここまで読んでくださった皆様にこの場を借りて御礼申し上げます。

川前 徳章 [かわまえのりあき]

エバンジェリスト

(データサイエンティスト)

2009年NTTコムウェア入社。大規模データの分散処理基盤の調査・導入から始まり、レコメンドシステム、情報検索、機械学習、自然言語理解と生成、AI等データサイエンスの研究開発とその導入に従事。現在は生成AIやマルチモーダルに向けたAIの研究開発を行っている。

各種データサイエンスに関する講演など対外的な活動も多く、KDD2021-、ICLR2022-、NeurIPS2021-、ICML2022-、AAAI2024-、WSDM2024-等のトップカンファレンスのPCや査読委員など、国内外でAIやデータサイエンス系の論文審査委員も多く担当している。2023年9月より上智大学大学院 非常勤講師も務める。

エバンジェリスト(データサイエンティスト)

- 川前 徳章

- NTTコムウェア株式会社

ビジネスインキュベーション本部

コラム一覧

- 生成AIの里 第四回:Promptがうまく言えなくて。。。:Pronto?Llama3、アンモナイトについて教えて!

- 生成AIの里 第三回:生成モデルと検索モデル(後編):昔のことが忘れられない―誤差逆伝播法はニューラルネットワークの呼吸である―

- 生成AIの里 第二回:生成モデルと検索モデル(前編):Prêt-à-porter ou haute couture?

- ACL2023に参加しました:カール起きて!ナイアガラ上空にジャコビニ流星が!

- 生成AIの里 第一回:How many LLMs must we learn?

- WSDM2023に参加/発表しました ―デジャブか類似か―

- KDD2022にも参加しました ―リソースと人生は有限、では無限なのは?―

- ICML2022に参加してきました ―深層学習は何階層?―

- 自然言語処理/理解を中心としたAIの動向、実用化進む「Chatbot」はここまで来た! <後編>AIが解く、「公園で遊ぶ犬の画像」―「芝」=?

- 自然言語処理/理解を中心としたAIの動向、実用化進む「Chatbot」はここまで来た! <前編>AIが測る言葉の距離?

- コムウェアは電気羊の夢を見るか?

- AAAI 2020に参加してきました ―データサイエンティストの熱狂―

- 哲学するAI~「愛」から「お金」を引いたら何が残るか~

- AIは人間の仕事を奪うのか?データサイエンスの視点から考える